AI) 정말로 LLM은 언어만 다뤄서 인간지능을 따라갈 수 없는 것일까?

개인적으로 생각하는 결론부터 말하자면,

“저걸 진심으로 주장했다면 나는 그 사람이 학자로써 뭔가 큰 걸 놓치고 있다”라고 생각해.

LLM의 출력 방식이나 내부 구조가 아닌 “세상을 언어로만 접하기 때문에”

인간지능이 다다를 수 없다고 한 게 진심이라면 어떤 게 문제가 될까?

![[질적연구방법론] 근거이론(Grounded Theory)연구란 무엇인가](https://i.ytimg.com/vi/NpOeC7Ghgns/maxresdefault.jpg)

대학교 수준 이상의 연구들의 대부분은 “이론 연구”와 그 이론 연구를 실현하는 단계의 연구로 나뉘어지는 게 대부분이야.

이론 연구 단계에서, 자료를 조사하고 가설을 설립하고, 자료를 조사하고,

기존 연구 성과들을 모아서 가설을 증명하려 하고, 가설에 대한 이론적 배경을 세워서 이론으로 만드는 것은 상식적인 단계지.

이 단계에서 이 단계를 실행하는 불쌍한 대학원생이 언어 외의 수단을 통해서 이 지식을 습득하고 있니?

아니, 전부 언어를 통해서 습득하고 있지.

이 불쌍한 대학원생은,

블랙홀을 연구한다고 해도 블랙홀에 대해 관측한 자료를 보지 실제로 블랙홀에 다가가서 빨려들어가보며서 연구하는 게 아니잖아.

물론 이론이 현실을 반영하지 못한다!는 주장은 있지만, 그런 상황에 대해서 정상적인 학자라면

“분석이 부족했다, 분석을 위한 자료 수집에 미비가 있었다” 하면서 불쌍한 대학원생의 논문을 리젝하지

“현실을 겪지 못한 언어적 경험만으로 너는 진정한 학문에 이르지 못했다” 같은 이야기는 안 하거든.

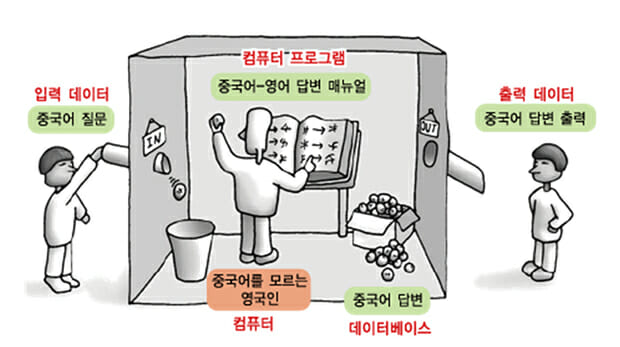

이쪽에서 유명한 게 중국어 방 논증이긴 해.

어느 방에 입구가 있고, 출구가 있는데, 입구에 중국어로 질문을 넣으면 출구에 중국어로 답변이 나오는 그런 방이 있거든.

근데 그 방 안에는 중국어를 모르는 노동자들이 들어온 입력에 따른 조작만 해서 답변을 만들고 있는 중인 거야.

그럼 그 방의 노동자는, 그 방은 중국어를 이해했을까? 하는 내용이야.

“컴퓨터가 프로그램에 따라 기호를 처리하는 것은 이해와 의식을 가질 수 없다”는 주장이지.

또 다른 논증은 흑백방의 메리 논증이라는 건데,

“흑백방에서 모든 물리학적 지식을 배운 과학자 메리는,

흑백방을 나와 실제로 붉은 색을 처음 봤을 경우 새로운 지식을 얻는가?” 하는 내용임.

붉은 색의 정의를 언어적으로 다 배운 메리가

이 붉은 색을 새로 처음 봤을 때 기존 지식에 없는 “경험”을 얻을 수 있냐는 소리.

전자는 반기능/계산주의의 대표와도 같은 논증이고,

후자는 반물리주의로 대표되는 이 세상에는 언어적 기술이 안 되는 물리적 사실 이상의 속성이 있다는 주장이야.

이 두 주장을 폄하하려는 건 아니지만, 이 질문들에 대한 반대 주장들도 있어.

사실 지금은 반대 주장이 더 세가 큰 경우가 많음.

더글러스 호프스태터는 중국어 방 논증에 대해서 이렇게 말했음

“사람은 모르지. 방 전체는 중국어를 안다고 해야지.”

이거도 꽤나 깔끔한 논증인 게,

내가 한국어를 할 줄 안다고 해서,

내 뇌의 일부를 떼어내면 걔가 무조건 한국어를 할 줄 아는 건 아니잖아?

내 뇌 전체를 구성하는 “나”는 한국어를 알아도, 내 일부가 무조건 한국어를 다 알 필요는 없거든.

이 경우 중국어 방이 하나의 두뇌고, 거기서 일하는 노동자는 뉴런이 되는 거야.

내부의 뉴런이 중국어를 몰라도 방이 중국어를 이해한 것처럼 작동하고 있으니 괜찮다는 논리임.

비슷하게 ,흑백방의 매리 논증에 대해서도 데이비드 루이스는 이런 주장을 함.

“메리는 빨간 색을 봤을 떄, 거기서 기존의 지식 이상의 새로운 “지식”을 얻은 게 아니다.

색을 보고 지식에 연결하는 기능을 얻었고, 그것이 바로 경험이다”.

Knowing what it is like(무엇인지를 앎)은 지식이 아니라 지식을 통합/얻는 과정에서의 행동적인 범위이며,

이건 무엇(that)을 아는 게 아닌 어떻게(how)를 정립하는 과정이다. 하고 답변한 거지.

즉 지식적으로는 더 안 게 없고, 새로운 "도구"가 생겼다고 답변한 거야.

다른 학자 ,다니엘 대닛은

“메리가 충분한 지식을 가지고 있을 경우

지금 자신의 시각세포에 들어오는 파장을 분석하여 붉은색을 본 순간 지식으로 이해했을 것”

이라며 반박하기도 했어.

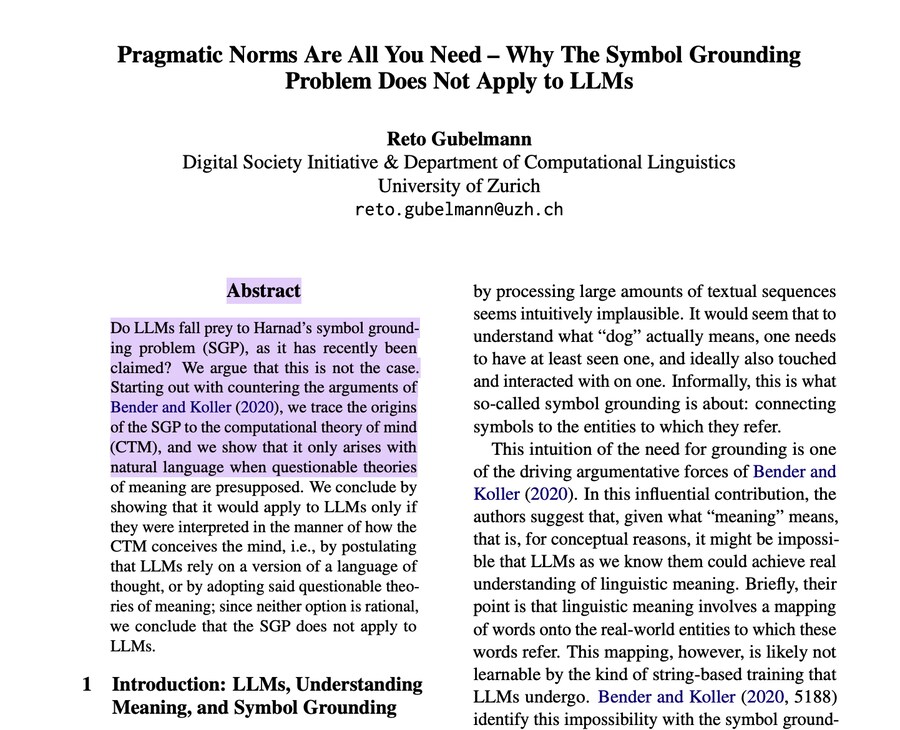

최근엔 또 재미있느 연구가 있는데,

https://aclanthology.org/2024.emnlp-main.651.pdf

언어를 완전한 기호로 보지 않고

특정 집단 내에서 사용되는 표현형(usage)로 볼 경우

이미 llm은 언어사용과 지식 함양에 있어서 agi에 거의 근접했고 도달할 수 있다는 의견임.

결국 본질적으로 우리가 "이것을 판단할 수 있다면 우리 집단에도 동일하게 적용해야 하는데 그럼 님들 의견 근간부터 터지는데 괜찮음?"이

llm이 agi가 불가능하다는 단순 의견에 대한 학계적 반박이라고 보면 돼.

지금 당장 된다 언제 된다가 아니라 "영원히 불가능하다" 어쩌구저쩌구에 대한 반박인 거지.

<="" 인물="" focus="" 기사본문="" -="" 인공지능신문"="">

<="" 인물="" focus="" 기사본문="" -="" 인공지능신문"="">

그와 별걔로 얘는 별로 믿음직스럽진 않긴 해

3줄요약

1. LLM이 정말 인간지능에 가까워질 수 없는 이유가 오로지 언어로 접근해서라면, 인간도 불가능하다

2. 언어적 관점으로만 봤을 떄 이미 꽤 근접했다고 판단하는 학자들이 있다

3. 그와 별개로 이게 맞는 방식이냐에 대해서는 의견이 갈리는 중